Category: Allgemein

Viele Jahre war die Seite kilo-byte.de sehr bescheiden. Nun wurde sie auf ein WordPress umgezogen. Die Blogeinträge über Computer und IT auf meiner Hauptseite schmidt-matthias.de sind nun hier aufgeführt. In Zukunft werde ich diese Themen hier verblogen, aktuelles, sowie Anekdoten aus der Vergangenheit. Demnächst also mehr Inhalt hier.

Einen Monat später sollte die Eingebung zur Rettung der Daten auf der Ursprungsplatte kommen. Mittlerweile waren die noch vorhandenen VMs auf einer großen Platte mit Debian als Host System umgezogen. Nach der Datenrettung wird dort zusammen mit der Ursprungsplatte ein RAID gebaut. Es wurde nochmal kniffelig.

Der Plan: Auf einer kleinen alten Platte wurde ein frisches FreeBSD aufgesetzt. Die mit Geli verschlüsselte Ursprungsplatte mit ZFS als zweite Platte und die Zielplatte mit LVM als dritte angeschlossen. Und los als root:

kldload fuse.ko was dann eigentlich nicht gebraucht wurde, ich dachte ext4 und lvm2 gehören zusammen, ist es aber nicht. Oder doch? Ich weiß es nicht.

# kldload /boot/kernel/geom_linux_lvm.ko # cd /usr/ports/sysutils/fusefs-ext4fuse/ # make install clean # mkdir /mnt/linux # ext4fuse /dev/linux_lvm/volumegroup-logicalvolume /mnt/linux

Wobei volumegroup-logicalvolume durch den entsprechenden Eintrag in /dev geändert wurde.

Toll, die Zielplatte war eingebunden. Leider kam ich mit der Ursprungsplatte genau so wenig weiter, wie einen Monat zuvor. Die Idee, im unverschlüsselten bootpool nochmal zu gucken, brachte mich weiter. So wie ich den Key rauskopiert hatte, konnte ich diese nochmal einbinden.

zfs import -N -f bootpool # forcefully import bootpool, but don’t mount it. zfs set mountpoint=/tmp/bootpool bootpool zfs mount bootpool

In /boot/loader.conf sollte alles benötigte stehen:

geom_eli_load=”YES” geli_da0p4_keyfile0_load=”YES” geli_da0p4_keyfile0_type=”da0p4:geli_keyfile0″ geli_da0p4_keyfile0_name=”/boot/encryption.key” vfs.root.mountfrom=”zfs:zroot” zfs_load=”YES”

Das sollte auf die Bootplatte, dachte ich, da0p4 auf da1p4 geändert natürlich. Im Eifer des Gefechts hatte ich vergessen, für LVM Einbindung der Zielplatte einzurichten. Aber das Hochfahren war exakt so, wie vor dem Upgrade Anfang September.

Ich war wieder auf dem ursprünglichen System!

Weil ich die LVM Einbindung vergessen hatte, war die Zielplatte zunächst nicht erreichbar. Ich kam nicht mehr in /boot. Das Kuriose nun war, die Ursprungsplatte konnte alleine wegen dem kaputten init nicht starten. Die frische FreeBSD Platte konnte nun auch nicht mehr alleine starten, wegen den loader.conf Einträgen. Beide Platten zusammen ermöglichten jetzt das Starten des ursprünglichen Systems.

Ich entschloss mich, das Debian normal zu starten, damit die VMs auch wieder online waren. Die beiden symbiotischen FreeBSD Platten kamen in einen Ersatz Rechner. Nun konnte, zwar langsam über Netzwerk, die Datenrettung beginnen. Und mit dem Vorteil, kopieren der Daten zeitgleich mit den laufenden VMs.

Gollum hatte wieder Glück gehabt.

Drei Tage totaler Server Ausfall

Am Freitag, den 1. September 2017, früh morgens ab drei Uhr, machte ich ein Upgrade des FreeBSD Host von Version 11.0 auf 11.1. Zunächst lief alles nach Plan. Doch eine Inkompatibilität versperrte den Netzwerkzugang der virtuellen Maschinen mit Virtualbox. Es begann eine Verkettung von Fehlern und meine Fähigkeiten schwanden. Auch der Mix aus neuen, alten und falschen Informationen im Netz, fast alles auf Englisch, hinderten mich an einer Lösung der Probleme. In den Foren war nicht klar zu entnehmen, ob es sich um einen Software Fehler oder um eine falsche Konfiguration handelt. Da bei der Release Version von FreeBSD Wochen vergehen können, bis Aktualisierungen verfügbar sind, plante ich, die VMs waren eh schon offline, ein Downgrade zurück auf 11.0. Das ging mächtig schief.

Vorwärts immer, rückwärts nimmer – Gilt wohl auch für BSD. Auf jeden Fall war das init sehr kaputt (Kernel panic: no init), das System nicht mehr startbar. Die Überlegung war, den FreeBSD Host auf einer anderen Platte nach zu bauen und die VMs und diverse Platten Images zu kopieren. Ich sollte hart scheitern. Das ZFS Dateisystem ist mit GELI verschlüsselt. Die Key Datei habe ich exportiert bekommen. Mir war es nach einen Tag nicht gelungen, das Dateisystem einzubinden. Es gibt irgendwelche ZFS allow/unallow Parameter und mit create und destroy war ich zurückhaltend, bevor etwas hätte überschrieben werde können. Fehler beim Denken verhinderten hier ein Weiterkommen. Der Plan war ursprünglich folgender:

mkdir /tmp/bootpool zfs import # lists the available pools to import. bootpool should be listed there zfs import -N -f bootpool # forcefully import bootpool, but don’t mount it. zfs set mountpoint=/tmp/bootpool bootpool zfs mount bootpool geli attach -k /tmp/bootpool/boot/encryption.key /dev/ada1p4 Enter passphrase:

Das Passwort konnte eingegeben werden, jedoch der folgende Befehl wurde verweigert:

zfs import -N -f zroot

Weiter hätte ich dies eingegeben_

mkdir /mnt/hd zfs create -o mountpoint=/mnt/hd zroot/zroot mount /dev/ada1p4.eli /mnt/hd

An die Daten auf der Festplatte kam ich nun nicht mehr heran. Ich hatte sie beiseite gelegt. Weil die Key Datei gesichert werden konnte, wurde das Rauskopieren vertagt, bis eine Eingebung mich weiter bringen wird.

Von den wichtigen VMs gab es ein Backup vom 19. August 2017, also knapp zwei Wochen alt. Den zweiten Tag scheiterte ich daran, den Host wieder so nach zu bauen, wie ich den vor ein paar Jahren gebaut hatte. Aus ein paar Gründen benötige ich ein minimales grafisches System, X11. Doch die Grafikkarte und nicht mehr weiter entwickelten Treiber untermauerten mein Versagen. Ich bekam es nicht mehr hin. Es wuchs in mir der Entschluss, den Host für die VMs mit Debian zu bauen.

Es bahnten sich schon lange Gründe an, warum Debian sinnvoller sein mögen, ich hatte die Denkweise, ein schlanken Host mit FreeBSD, konservativ und stabil. Da aber noch Drucker, Scanner usw. irgendwann wieder genutzt werden könnten sollte, die FreeBSD entweder wegen der fehlenden Treiber oder des nicht durchschleusbaren USB 2.0 mit Virtualbox nicht unterstützt, sollte ein Wechsel zu Debian stattfinden.

Die aktuelle Version von Debian 9.1.0 hat einen kaputten Netzwerkmanager, es empfiehlt sich, von 9.0.0 zu installieren, alles einzurichten und erst dann das System upzugraden. Diese Erkenntnis hatte ich nach einem dreiviertel Tag später dann auch.

Endlich konnten neun VMs umziehen und wieder gestartet werden. Endlich auch wieder Freifunk verfügbar. Ein RAID System wäre auch für mein Server gut, jedoch in diesem Fall hätte genau das nicht gereicht. Die Backups haben mir sehr viel Arbeit erspart, auch wenn der Speichstand zwei Wochen alt war. Es sind ein Protokoll im Wiki und Eintragungen im Wekan abhanden gekommen, aber diese sind noch auf der Ursprungsplatte. Vielleicht ist da doch noch ein Herankommen.

Meine kognitive Dissonanz, da steht z.B.

zfs allow -u someuser send,snapshot mypool

in der Anleitung, aber someuser und mypool muss anders sein. Also ich habe starke Problem bei Anleitungen zu sehen, welche Teile eines Befehls an das eigene System angepasst werden muss. Ich kann mir Vokabeln schlecht merken, daher immer wieder Probleme mit Syntax, Variablen usw.

Die drei Tage waren mit sehr viel Müdigkeit verbunden, die Hälfte der Ausfallzeit habe ich geschlafen. In einer Bank oder in einem Konzern wäre das “Durchmachen” Pflicht des Admin gewesen. Daher habe ich wieder große Zweifel, jemals beruflich den Quereinstieg zu schaffen. Ich kann das nicht leisten.

Würde ich die Admin Tätigkeit beruflich machen, würde nicht alles auf einem Server laufen. Wäre etwas mehr Geld verfügbar, gäbe es zwei separate Internetanschlüsse, jeweils mit zwei Server mit RAID als Clusterverbund und ein Speichersystem für Backups mit kürzeren Speicherzyklen.

An dem Konzept dezentrales Internet möchte ich festhalten. Jedoch 72 Stunden Ausfall mit Datenverlust sind nicht verzeihbar, das darf nicht passieren. Die Fähigkeiten sollte ich sehr bescheiden sehen. Ich mache nach wie vor viel zu viele Fehler. Ich muss gebremst werden.

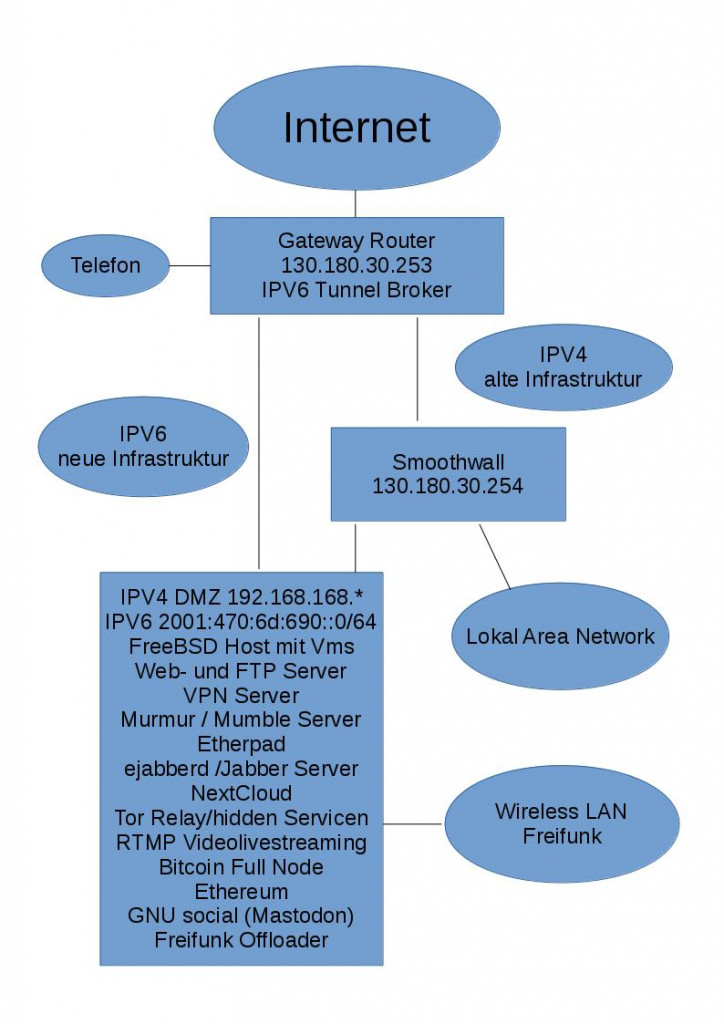

Besser spät, als nie, nun gut. Morgen, am 6.6. ist wieder #IPV6Day. Als erstes dachte ich, dass an dem Tag IPV4 blockiert wird. Es ist aber wohl so, dass es darum geht, neben IPV4 IPV6 einzuschalten und DNS AAAA Records einzutragen. Endlich sind meine Server auch so angeschlossen, bzw. die wichtigen VMs. IPV4 kann meinetwegen begraben werden.

So sieht zur Zeit mein Netzwerk aus:

Seit einiger Zeit läuft der Homeserver über eine feste IPV4 Adresse mit einem bussiness Vertrag. Leider bietet der Provider keine IPV6 Adressen an. Ich habe mich nun dem Thema IPV6 gestellt. Ich hatte Vorurteile, die ich nun widerlegen konnte. IPV4 und IPV6 haben so einige Unterschiede, jedoch ist die Menge des zu Lernenden etwa gleich. Ich habe jetzt einen IPV6 Tunnel und der Server kann so erreicht werden. Seit über 20 Jahren soll das Internet nun umgestellt werden, IPV4 hält sich konservativ. Auch ich bin viel zu spät dran am Thema und werde mir die Frage stellen müssen, warum nicht eher. Ich hatte Sorge mit den langen Adressen. Nun habe ich einige Seiten über IPV6 gelesen und das praktische Umsetzen hat mir geholfen, keine Sorgen mehr zu haben. Nach einem halben Tag des Studiums und des Einrichtens des Netzwerkes habe ich das grundsätlich alles verstanden. Ich bin froh, dass die Konzentration besser geworden ist und ich noch ein wenig lernen kann. Meinetwegen kann IPV4 abgeschaltet werden.

Spät am Abend des 23.02.2017 fielen mir URL-Shortner Links in einigen Beiträgen auf. Seit wenigen Tagen gibt es wichtige Updates, ich war etwas zu spät damit. Somit kann diese WordPress Instanz als kompromitiert gelten. Aber so ist das dann mit php Haufen, nur jetzt weiß ich es genau.

Ich teste gerne Dinge auf meinem Server, versuche aber Fehler, die anderen Personen oder das Netz schaden, zu vermeiden. In letzter Zeit wurde häufiger über das Tor Netzwerk berichtet. Ich bin zudem ein politischer Mensch. Es ist wichtig, dass es Zugänge gibt, wenn Dinge in der Politik oder Wirtschaft schief laufen, dass informiert werden kann. Daher mein Entschluss, ein Tor Relay laufen zu lassen. Der Server soll Anfragen vom Tor Browser zulassen und in das Tor Netzwerk weiterleiten. Auch sollen ander Tor Nodes Daten weitergeleitet werden. Ich möchte an meinem Internetanschluss jedoch keine Daten aus dem Tor Netzwerk in das öffentliche Internet weiterleiten. Als lerneder und interessierter Admin richtete ich ein Webserver als Hidden Service ein.

Es trat ein Konfigurationsfehler meinerseit auf. Ich benutzte die Anleitung von der Tor Projekt Seite www.torproject.org . Von der IP Adresse 130.180.x.x , meine öffentliche und feste IP Adresse für meinen Server kilo-byte.de wurde vom 18. Dezember 2016 bis zum 30. Januar 2017 unerwünschter Weise ein Tor Exit Node betrieben. In den letzten Tage konnte ich selbst viele Seiten nur noch mit Capcha Code aufrufen. Ich fing an, zu überprüfen, was falsch lief. Die Anleitung auf https://sites.google.com/site/stefansitpage/dokumente/tor-relays-auf-debian zeigte mir deutlich, dass bei meiner Konfiguration, das Auskommentieren der Zeile “Exitpolicy reject *:*” fehlte. Sofort behebte ich den Fehler. Es war nicht meine Absicht. In den sechs Wochen sind etwas über ein Terabyte an Daten über den Tor Node übertragen worden. Es kann vermutet werden, dass manche Daten nicht die besten sind. Es wurde auf dem Server nichts protokolliert und mir sind keine Straftaten aus diesem Zeitraum bis heute, 3. Febura 2017 bekannt. Dieser öffentliche Beitrag soll dazu dienen, dass es keine Ansicht war, ein Tor Exit Node zu betreiber. Mir ist dennoch bewust, haftbar zu sein. Auf Twitter hatte ich schon unmittelbar nach dem Auffinden des Fehlers berichtet.

Bei der Recherche fand ich auf cleantalk.org , dass vom 19. November 2016 bis zum 27. Januar 2017 unerwünschte E-Mails verschickt wurden. Es gab von meinem Internetanbieter Unitymedia eine Abuse Meldung am 16. Dezember 2016. Ich nahm Kontakt auf. Es war eine für mich nicht nachvollziehbare Info, da von Windows PCs und der Schadsoftware Zeus die Rede war. Bei mir sind keine Windows PCs mehr im Einsatz. Ich habe zwei virtuelle Maschinen mit Windows 10, eine ohne Netzwerkanbindung und die andere bekommt alle paar Wochen Updates, wird aber sonst auch nicht benutzt.

Nach meinem Kenntnisstand von heute, 3. Febura 2017 muss noch eine weitere Lücke bestehen. Der Tor Node kann erst ab den 17. oder 18. Dezember 2016 in Frage kommen, da erst ab diesen Zeitpunkt meine neue Workstation geliefert wurde und ich mit mehr Ram weitere VMs nutzen konnte. Es gibt auf dem Webserver Kontaktformulare und Logins usw. z.B. WordPress, mit viel php usgbdri. Als Admin, aber kein Programmierer kann ich stets nur für regelmäßige Updates sorgen. Ich versuche achtsamer zu sein.

Ich habe eine Frage? Wie zuverlässig sind die Online Datenbanken? Ich habe einige Seiten gefunden, die Aktivitäten der IP Adresse zeigen. Es sind oft Fehler zu sehen, welchem Provider die Adresse zugeordnet ist. Wenn diese Angaben schon falsch sind, in wie weit können Einträge manipuliert dort eingegeben werden? Das Monitoring basiert auf Reaktionen von Firewalls usw. Können die manchmal irren? Ich veruche das zu klären und werde häufiger meine IP Adresse in Suchmaschinen nachforschen, was passiert.

Ab dem Frühjahr 2000 war ich online mit einer 56kBits mittels Elsa Modem Anbindung. Im Herbst des gleichen Jahres hatte ich dann schon die erste eigene Webseite. Ich hatte mich schnell in html eingearbeitet. Nach kurzer Zeit durfte eine Webcam nicht fehlen. Ich nutzte ein Modell von Creativ, die Firma war mit PC Soundkarten bekannt. Die Cam hatte eine Auflösung von 640×480 Bildpunkten, die Bildqualität war sehr gut.

Sobald ich online war, wurde alle fünf Minuten ein Bild hochgeladen. Die Auflösung war 320×240 Bildpunkte und das Bild war auf unter 7 Kilobyte komprimiert. Das sah dann so aus:

Ab Anfang 2002 erfuhr ich von Streaming und von allerhand Problemen. Im Audioberreich konnte ich ab 1996 mit einer Soundblaster AWE32 und meinem ersten CD-Brenner Phillips CDD2000 Musik CDs mit guter Qualität aufnehmen und brennen. Ein Pentium mit 100Mhz, 64MB Ram und 1,3GB HDD reichte völlig aus. 2001 kaufte ich den ersten DVD Brenner, von Pioneer, die große Frage stellte sich, setzt sich DVD-R oder DVD+R durch. Das war bei den Playern relevant. Dazu hatte ich die Hauppauge PVR Videokarte, die in Echtzeit mpeg1 und mpeg2 kodieren konnte. Der Rechner hatte ein Thunderbird 1,1 GHz Prozessor, 1GB Ram und eine 80GB Festplatte. Bevor ich mich anfing, für Livestreaming zu interessieren, konnte ich Audio CDs und Viedeo DVDs erstellen und gegebenfalls einen Livemitschnitt machen. Bei Liveaufnahmen war das immer eine wackelige Angelegenheit, dass der Rechner sich nicht aufhängt. Mit digital-analog-digital Kopien konnte der meiste Kopierschutz umgangen werden mit sehr geringen Qualitätsverlusten.

Ins Internet live senden, das packte mich. Aber Bandbreite war teuer, jeder Stream addierte sich. Es gab theoretische Ansätze, ein Stream und bei Bedarf, ein Spltten an jedem Knotenpunkt, dass das ganze Netz bei dedarf mit einem Stream erreicht werden sollte. Unicast oder Multicast war das. Sowohl die Encodersoftware als auch die Server (-software) waren unbezahlbar und für Medienkonzerne gedacht. Mit dem Microsoft Media Encoder konnte ich die ersten Erfahrungen machen, da dieser vom Client auch direkt angesprochen werden konnte. Mit der 56k Leitung war da kaum was zu machen und zunächst blieb der Erfolg aus.

Ende 2002 gab es da, wo ich wohnte und für mich bezahlbar den ersten DSL Anschluß. 768kBits empfangen und 128kBits senden. Auf dem ersten W-LAN waren wir zu dritt und teilten uns die Leitung. 2003 stand dann ebenfalls der erste Webserver zu hause. Eine Smoothwall als Router schützte das interne Netz und regelte die Priosierung der Datenströme. Statt alle paar Minuten nur ein Bild hochzuladen, war die Webcam nun ein echter Livestream mit 32kBits, ohne Audio. Maximal vier Clients konnten zusehen, leider nur mit dem Windows Media Player, der aber in die Webseite sich intigrieren ließ. Radiomoderation habe ich nie gemacht.

Die folgenden Jahre passierte wenig mit dem Livestreamen, die Leitungen wurden dann und wann schneller.

Ab 2012 wurde das Livesenden und Aufzeichnen von Videos für meine ehrenamtliche Tätigkeit relevant. Die Kunst, mit wenig Budget viel machen. Schon etwas vorher hatte ich äußerst gute Erfahrungen mit dem Videograbber EasyCAP gemacht. Audio ist sehr schlecht und sollte anders in den Computer gelangen. Aber im Dauerstreamen ist das Ding genial, Monate lang ist kein Problem damit.

Als Kamera macht eine Canon FS100 gute Dinste. Auf einer 32GB SD-Karte kann ein ganzes Wochenende einer Veranstalltung gespeichert werden, in DVD Qualität. Die direkte Speicherung macht Sinn, der PC kann da unzuverlässig sein. Bei Sonnenlicht ist das Bild sehr gut, in dunkleren Räumen nur mäßig. Das Mikrophon hingegen ist sehr gut und reicht meistens. Wenn die Versammlung größer ist, werden mehere Mikrophone und ein Lautsprecher benutzt und per Line-in das Signal direkt in die Kamera gegeben. Von dort wird das Video Signal an den Videograbber und das Audio Signal an die Soundkarte weitergeleitet.

So gelangen die Daten in den Computer. Zwischen 2012 und 2015 nutzte ich einen Stream Hoster in Italien. 10Mbits, später 20MBits Flat für den ganzen Monat für 12€. Es war ein Flash Media Server und ich nutzte den Flash Media Encoder. Die meiste Zeit streamte die Webcam mit der Gegend zu Hause und bei Veranstalltungen wurde der Server dafür genutzt. Die Veranstalltungen hatten meist regionalen Bezug. Da noch nicht mit dem Breitbandausbau begonnen wurde, war derLivestream auf 320kBits beschränkt. Die Leute sollten sich live in die Veranstalltung einbringen können über soziale Medien. Dazu sollte der Stream nach Möglichkeit auch im Umland funtionieren. Außerdem war am Veranstalltungsort der Uplink auch bescheiden. Mit dieser Bandbreite konnte auch mehere Stunden pro Monat über UMTS/LTE gestreamt werden, bis das Datenvolumen verbraucht war. So konnten mit 320kBits bei Events 60 Clients zugucken und die Webcam mit 64kBits 320.

Die Aufnahmen auf der Speicherkarte können mit dem richtigen Codec kodiert werden und auf Webseiten eingebunden werden zum späteren nachgucken. Für Videohosting kann viel Resourcen von Nöten sein, wenn die Qualität gut sein soll.. Ich selber handhabe das so, wie viele andre auch und nutze Youtube für das Hosten und für den Livestream.

Flash ist obsulet, aus Gründen. Die ganzen Jahre war ich außrdem abhängig von WinDOS, was den Encoder betrifft. Nach wie vor sieht es bei der Software so aus, dass das Thema kommerziell geprägt ist. Mit Linux hatte ich jahrelang keinen Erfolg. GUI sind unbrauchbar sehr oft. Bis vor ein paar Tagen war das so.

Doch Ende 2016 habe ich die Zauberformel im Internet für ffmpeg auf Linux gefunden für Livevideostreaming:

ffmpeg -f alsa -ac 2 -i hw:2,0 -f v4l2 -s 720×576 -r 10 -i /dev/video1 -vcodec libx264 -aspect 16:9 -preset ultrafast -r 25 -g 20 -b:v 850k -codec:a libmp3lame -ar 44100 -threads 6 -b:a 96k -bufsize 512k -f flv rtmp://a.rtmp.youtube.com/live2/Session-Id

Das ganze läuft Resourcen schonend und stabil im Textmodus.

Es gibt mittlerweile eine Mobilfunkfirma, wo die Datendrosselung bei 1Mbits liegt, damit kann in fast DVD Qualität gestreamt werden, den ganzen Monat. Eine andere Firma bietet LTE max für 24 Stunden an für 10€. Da geht HD Streaming.

Insgesammt eine gute Entwicklung bei dem Themenkomplex. Ich bleibe motiviert.

Der vielleicht schrottigste Computer, den es je gab

Atari 2600 Spielekonsole mit Compumate von Spectravideo,

vertrieben von Universum Quelle

Atari 2600 seit 1977 mit 126 Byte ! Ram

und 6507 Prozessor 1,19 MHz

mit Compumate ab 1984 mit 1750 Byte Ram und

16 KB Rom (für Betriebssystem Basic)

42 Tasten, Grafik 40×40 Pixel, 8 von 256 Farben, 2 Kanalton über

2 Oktaven mono, EAR/MIC Anschluß an Cassettenrecorder